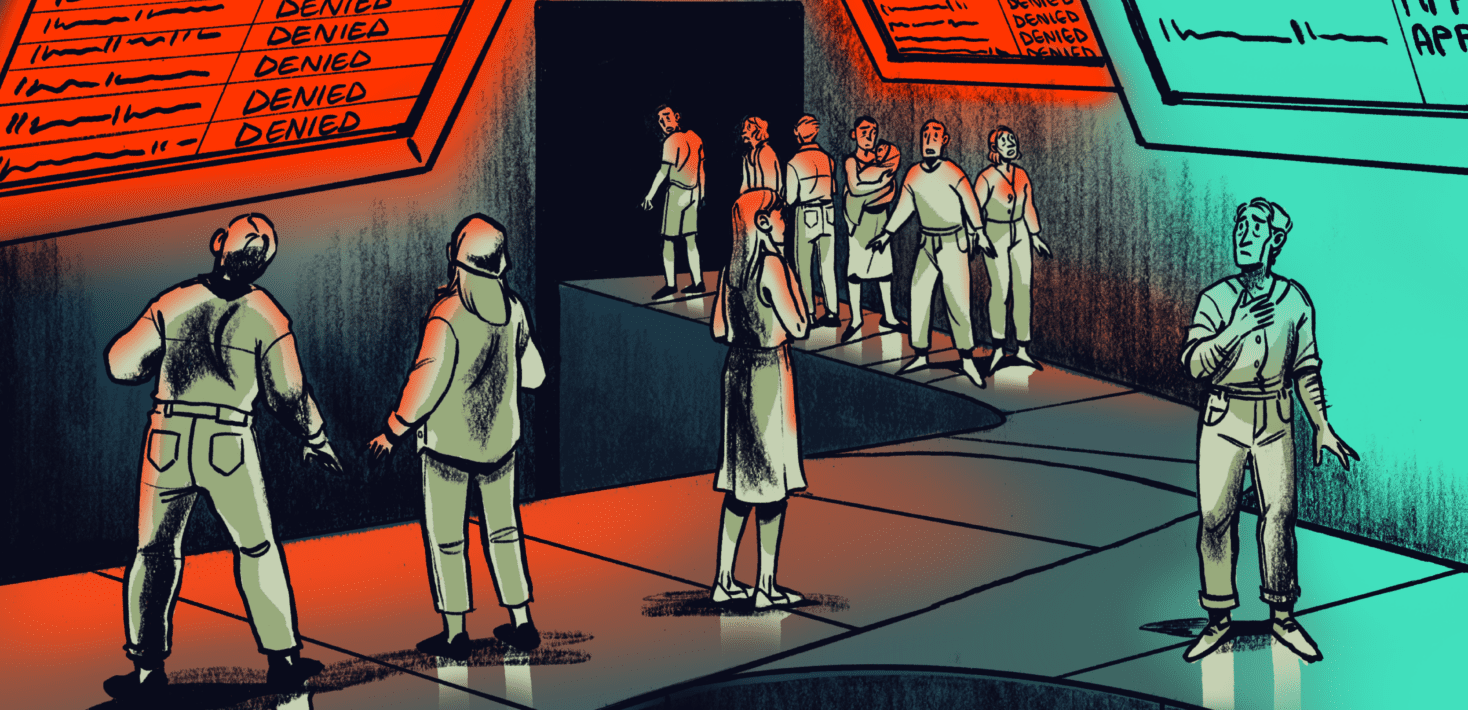

Les technologies numériques, notamment l’intelligence artificielle, l’automatisation et la prise de décisions à l’aide d’algorithmes aggravent les inégalités dans les systèmes de protection sociale à travers le monde, indique Amnesty International dans un nouveau rapport rendu public mercredi 6 mars.

« De la Serbie, à l’Inde, en passant par les Pays-Bas, ces technologies sont présentées par les gouvernements comme des solutions de pointe pour assurer une meilleure distribution des ressources, améliorer les systèmes administratifs, détecter les fraudes et renforcer la sécurité. Cependant, les recherches d’Amnesty International ont révélé que la numérisation non contrôlée des systèmes de protection sociale présente de nombreux risques pour les droits humains et aggrave les inégalités, a déclaré Imogen Richmond-Bishop, chercheuse d’Amnesty Tech sur la technologie et les droits économiques, sociaux et culturels.

« Face aux multiples crises mondiales causées notamment par les conflits, l’urgence climatique et la pandémie de COVID-19, il est plus que jamais essentiel d’avoir de solides systèmes de protection sociale pour protéger les personnes et les communautés contre l’insécurité économique. »

Le nouveau rapport, intitulé La protection sociale à l’ère numérique, met en évidence les risques de l’utilisation incontrôlée des technologies numériques pour les droits humains.

Les populations qui seront impactées par un système doivent être consultées et tout changement concernant ces systèmes d’aide vitale doit être communiqué de manière claire et accessible. En particulier, s’il s’avère qu’un système risque de causer des préjudices en termes de droits humains et que ce risque ne peut pas être évité efficacement, il ne faut jamais déployer ce système

Imogen Richmond-Bishop, chercheuse d’Amnesty Tech sur la technologie et les droits économiques, sociaux et culturels

Le registre serbe relatif aux cartes sociales est un parfait exemple d’utilisation d’un processus de décision semi-automatisé dans un système d’aide sociale déjà défaillant, qui impacte de façon directe les populations déjà marginalisées, comme l’a montré Amnesty International dans un rapport publié en 2023. La technologie employée, qui a été mise en place sans garde-fous suffisants et sans protections pour les droits humains, a eu des effets particulièrement néfastes sur les communautés roms et les personnes en situation de handicap.

Le système a amplifié la discrimination existante et créé des obstacles supplémentaires pour l’accès au droit à la sécurité sociale. Beaucoup de personnes interrogées par Amnesty International ont perdu leurs maigres aides financières, ce qui a interrompu leur accès à des biens et services de première nécessité, tels que la nourriture et les médicaments, à cause des lacunes du registre des cartes sociales.

En Inde, le système d’identification biométrique Aadhaar – qui attribue un numéro d’identification unique à tous les citoyens et résidents, y compris les enfants – sert à vérifier et authentifier les informations d’identité pour de nombreux services publics, dont les prestations sociales et les rations alimentaires. Il repose entièrement sur des outils numériques. Toutes les recherches menées notamment par des journalistes et des membres de la société civile ont conclu que son utilisation a conduit à l’exclusion de nombreuses personnes d’une protection sociale qui leur était vitale.

« Il est essentiel que les États, avant d’introduire la technologie dans les systèmes de protection sociale, étudient attentivement les risques potentiels de son déploiement pour les droits humains. L’utilisation de toute technologie doit être accompagnée d’une évaluation indépendante et fiable de l’impact en termes de droits humains tout au long du cycle de vie du système, de sa conception à son déploiement, et des mesures efficaces d’atténuation des risques doivent être mises en place, a déclaré Imogen Richmond-Bishop.

« Les populations qui seront impactées par un système doivent être consultées et tout changement concernant ces systèmes d’aide vitale doit être communiqué de manière claire et accessible. En particulier, s’il s’avère qu’un système risque de causer des préjudices en termes de droits humains et que ce risque ne peut pas être évité efficacement, il ne faut jamais déployer ce système. »

Complément d’information

En 2023, un rapport d’Amnesty International intitulé Pris au piège de l’automatisation. Pauvreté et discrimination dans l’État-providence en Serbie, a montré que de nombreuses personnes, en particulier des Roms et des personnes en situation de handicap, n’étaient pas en mesure de payer leurs factures ou de nourrir leur famille et éprouvaient des difficultés à joindre les deux bouts après avoir été privées d’allocations à la suite de l’introduction du registre des cartes sociales.

En 2021, Amnesty International a rassemblé des informations montrant qu’un système algorithmique utilisé par les autorités fiscales néerlandaises avait procédé à un profilage ethnique des bénéficiaires d’allocations familiales. Cet outil était censé vérifier si les demandes de prestations sociales étaient légitimes ou frauduleuses, mais le système a en fait injustement pénalisé des milliers de parents à faible revenu ou immigrants en les faisant plonger dans un endettement exorbitant et dans la pauvreté.